«Жутко греет плохо приспособленное помещение…» – написал как-то в одной из своих юморесок живой классик разговорного жанра Михаил Жванецкий о тяжкой судьбе американского компьютера, попавшего в советскую действительность 1980-х годов. Шутки-шутками, но качественное охлаждение абсолютно необходимо для надежной работы серверов, сетевого оборудования и других элементов, на основе которых сегодня создаются современные дата-центры.

Эволюция дата-центров

Когда Интернет еще только начинал свое триумфальное шествие по планете, операторы связи стали предлагать своим клиентам возможность устанавливать серверы в собственных узлах связи – естественно, в пакете с услугами связи оператора-владельца. Такое «совместное размещение» получило название colocation (co-location или colo), калька с которого пришла и в русский технический сленг – «колокация», «колокейшн». В те времена стоимость электроэнергии составляла лишь малую часть от всей стоимости владения компьютерным «железом» и программным обеспечением, поэтому серьезного внимания энергоэффективности не уделяли.

Ситуация поменялась к концу 1990-х, когда стоимость энергии, потребленной сервером за время его жизни, стала превышать цену самого оборудования. Тогда, прежде всего в США, стали развиваться крупные дата-центры, предлагающие размещение оборудования как самостоятельную услугу. Появилось новое понятие – carrier-neutral, т. е. дата-центр, не принадлежащий оператору связи, в котором может обеспечиваться свободный доступ для любого оператора по выбору клиента. То есть сформировался самостоятельный рынок услуг размещения, не являющихся приложением к услугам связи.

В этой новой рыночной нише уже появляются компании, для которых основной задачей становится эффективность и надежность работы инженерных систем. Укрупнение дата-центров позволяет использовать эффект масштаба, чтобы предоставлять качественный сервис по весьма умеренным ценам. Вводятся объекты мощностью в мегаватты и десятки мегаватт. В обостряющейся конкурентной борьбе каждый процент расходов на потери и охлаждение начинает иметь все большее значение. Надо не только экономить энергию, но и обеспечивать умеренную стоимость самого оборудования, добиваться снижения затрат на обслуживание, а также обеспечивать длительный срок службы узлов и компонентов.

Российская специфика

По понятным причинам развитие этого рынка в России отстает от США примерно на десятилетие. Например, первый коммерческий carrier-neutral colocation дата-центр в Москве под брендом «Стек» открылся только в 2004 г. Массовый старт проектов, ориентированных на энергоэффективность, пришелся у нас на 2011–2012 гг.

В начале 2000-х многие эксперты, экстраполируя рост потребления ИТ-оборудования, приходили к выводу о том, что после 2010 г. надо ожидать выхода на средний уровень более 15 кВт на стойку. Сейчас можно с уверенностью сказать, что средняя мощность на стойку в коммерческих дата-центрах стабилизировалась где-то на уровне около 5 кВт, а мощность 10–12 кВт потребляют отдельные группы размером до 20 стоек, принадлежащие облачным провайдерам.

Системы охлаждения

Техническую эволюцию систем охлаждения кратко можно представить следующим образом.

На начальном этапе серверные комнаты имели фальшпол, под который так называемые прецизионные кондиционеры гнали холодный воздух, чтобы он выходил через решетки перед стойками с оборудованием. Поскольку большинство офисных зданий располагали централизованной системой кондиционирования на охлажденной воде (отсюда, кстати и происходит слово «чиллер» – установка, производящая chilled water – охлажденную воду), то ее и подавали в кондиционеры.

Но по мере роста объектов проектировщики стали использовать выделенные системы снабжения охлаждающей жидкостью. Дата-центры обзавелись собственными чиллерами, градирнями, насосами и трубопроводами. Для повышения бесперебойности в работе стали применять так называемое взаимное резервирование компонентов и трубопроводов. Для гарантированного питания систем охлаждения систем обычно использовали те же дизель-генераторные установки, которые подавали питание на ИБП.

Классическая схема имела некоторый потенциал оптимизации, в частности, в нее были добавлены радиаторы «свободного охлаждения», которые отводят хотя бы часть тепла, пока температура воздуха на улице ниже, чем у теплоносителя, снижая нагрузку на компрессоры. Чтобы увеличить количество дней, когда такой режим используется, подняли рабочую температуру теплоносителя, что, конечно, потребовало увеличения площади теплообменников в зале, зато сократило образование конденсата.

Практическим пределом такой оптимизации является уровень среднегодового расхода энергии на охлаждение до 40% от ИТ-нагрузки.

Варианты оптимизации систем охлаждения

В поисках путей дальнейшего улучшения были опробованы разнообразные решения.

В 2014 г. Microsoft в рамках своего проекта Natick погрузила капсулу с серверным оборудованием на глубину до 10 м у Тихоокеанского побережья. 105-дневыне испытания прошли вполне успешно. С охлаждением, естественно, никаких проблем не возникло, тем не менее, похоже, что желающих доверить свои серверы и данные Нептуну с тех пор так и не нашлось.

Было построено несколько дата-центров которые сбрасывают тепло в подземные воды, холодные глубины морей или озер. При всей привлекательности этой идеи возникают сложности, связанные с коррозией, а также возражения экологов, которые опасаются разбалансировки экосистем водоемов.

Водяное охлаждение самих серверов прижилось только в секторе суперкомпьютеров. Все-таки коммерческий дата-центр должен позволять заказчикам размещать широкий спектр стандартного оборудования.

Прямая вентиляция (естественно с фильтрацией и управляемым подмесом) хорошо работает в специализированных дата-центрах Google, Facebook и «Яндекс», которые согласились максимально расширить допуски по влажности и ограничили требования по пыли. Архитектура информационных систем этих компаний позволяет не обращать большого внимание на выход из строя отдельного сервера. Однако широкий круг обычных клиентов не готов так рисковать своим оборудованием.

Привлекательной выглядит идея полностью отказаться от холодильных компрессоров и обойтись испарением воды во внешнем воздушном контуре. К сожалению, анализ климатических данных показывает, что даже в Москве и Санкт-Петербурге будет примерно неделя в году, когда температура в серверном зале превысит 28 °С.

И все-таки в заданных граничных условиях (размещение стандартного оборудования в нормальных условиях) есть возможность устранить узкие места и добиться существенной экономии. Главное – это рассматривать систему целиком, включая и здание, и само охлаждаемое серверное оборудование.

Узкие места существующих систем

Первым узким местом зачастую является само здание. Даже при достаточно глубокой реконструкции существующего здания все же приходится идти на существенные компромиссы, из-за которых заметная часть энергии уходит на свист в воздуховодах и журчание в трубопроводах, а зажатый в узком дворе «чиллер» уже в мае работает при сорокоградусной жаре.

Радикальным решением здесь является строительство нового здания на свободной площадке. Если использовать сэндвич-панели, то при умеренных сроках и стоимости можно возвести надежное здание с достаточной степенью герметичности.

Следующим традиционно узким местом становится фальшпол. Даже при двухметровой высоте, лес стоек здесь создает заметное сопротивление, но наибольшие потери вносят выходные решетки, которые нельзя сделать ажурными, поскольку они должны выдерживать значительный вес.

Высокое сопротивление пола приводит еще и к неправильному распределению охлаждающего воздуха: менее мощное оборудование получает избыток, а более мощное задыхается от недостатка подачи. Приходится ставить плитки с дополнительными вентиляторами, что также требует и денег, и энергии.

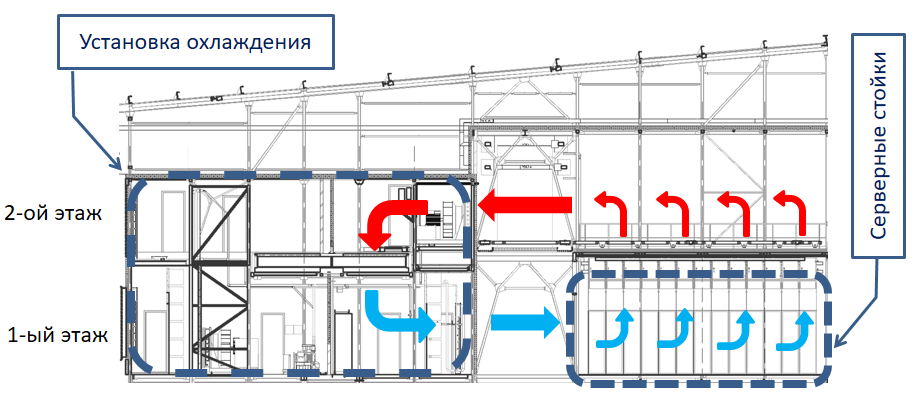

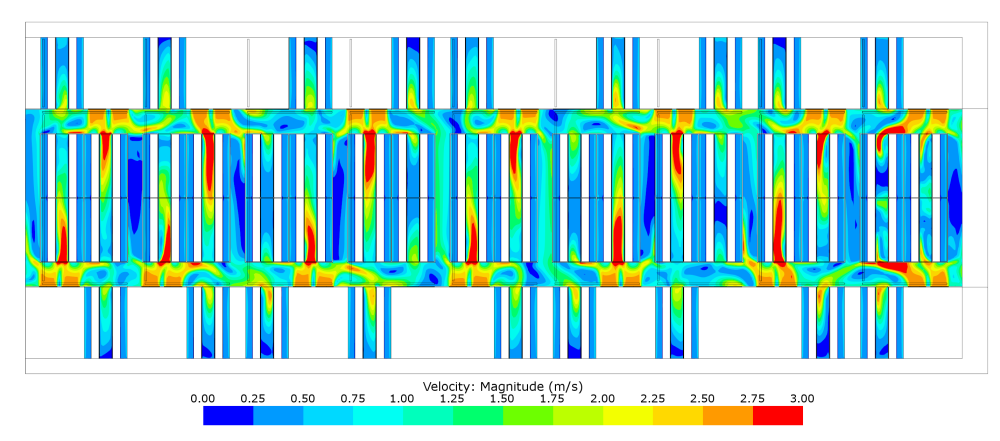

Рациональным выбором становится полный отказ от фальшпола. Это заметно экономит средства, упрощает перемещение стоек по залу, а главное, отдав все коридоры первого этажа для распределения холодного воздуха, мы можем обеспечить его плавное течение со скоростью до 3 м/с. При такой скорости практически не образуется вихрей, нет эффекта Бернулли, каждый сервер может всосать столько холодного воздуха, сколько требуется – автоматика управления вентиляторами современных серверов весьма точно регулирует их производительность.

Рис. 1. Организация воздушных потоков без фальшпола (ДЦ Xelent)

Раз уж мы строим новое здание, специально для дата-центра, то никто нам не помешает спроектировать второй ярус и отдать его для эвакуации горячего воздуха. Таким образом мы получаем контур циркуляции без узких мест и естественное перераспределение нагрузки между установками охлаждения, в том числе и для взаимного резервирования.

Рис. 2. Моделирование аэродинамических потоков в сервером модуле ДЦ Xelent (расчет выполнен ООО «ММ-Технологии»)

Поскольку основные затраты энергии в системе охлаждения связаны с работой компрессорных холодильных машин, нужно добиться максимального использования пассивного охлаждения, чтобы отдавать тепло за счет перепада температур. Если добиться хорошей изоляции потоков воздуха в серверном зале, то в горячем коридоре температура будет до 32 °С и выше. Пока на улице холоднее, теоретически можно хотя бы часть тепла отдать за счет перепада, почти бесплатно.

На практике же приходится сталкиваться со следующим ограничением. В классической системе теплу приходится преодолевать как минимум 4 границы: воздух-металл-вода (радиатор кондиционера), вода-металл-воздух (радиатор градирни). На каждой границе хорошо бы иметь перепад в три градуса: 4 × 3 = 12º. Значит, режим полностью пассивного охлаждения будет работать, когда на улице ниже 10 °С, а сколько-нибудь заметную помощь чиллеру будет оказывать примерно до 20 °С.

Современные теплообменники

Известный шведский производитель теплообменников Alfa-Laval предлагает решение Arctigo LSV (Low Speed Ventilation), в котором за счет значительного увеличения размера радиаторов перепад на каждой границе уменьшается.

Увеличенный размер радиатора в серверном зале также способствует тому, чтобы циркуляция воздуха в зале происходила без вихрей с умеренными скоростями. Однако здесь все равно присутствует жидкий теплоноситель, который необходимо постоянно перекачивать, а также принимать меры для исключения утечек.

Можно ли обойтись без жидкости и получить высокую эффективность? С 2008 г. нидерландская компания KyotoCooling предлагает установки на основе роторных теплообменников.

Роторные теплообменники (также называемые тепловыми колесами) уже давно используются в различных отраслях промышленности, прежде всего в качестве рекуператоров. В рекуператорной схеме включения в системах вентиляции, например зимой, ротор забирает тепло у отходящего воздуха и отдает его приточному. За счет этого удается значительно экономить на отоплении. В металлургии аналогичным образом подогревается воздух для мартеновских печей за счет тепла отходящих газов.

Сердцем установок KyotoCooling является алюминиевый ротор, включенный по схеме переноса тепла. Ротор представляет собой диск, сформированный из гофрированного алюминиевого листа. На специальной установке алюминиевая лента навивается подобно магнитофонной ленте, от центра к краю большого диска. При этом на ленте формируются складки, а на поверхность наносится эпоксидный лак. В результате получается огромная «таблетка», сплошь пронизанная миллиметровыми каналами в осевом направлении – от одного торца к другому. Воздух может проходить по направлению каналов, но не растекается в других направлениях. Ротор установлен таким образом, что одна его половина оказывается во внутреннем контуре циркуляции воздуха, а другая продувается внешним воздухом. При каждом полуобороте эти половины меняются местами.

Поскольку алюминий отлично проводит тепло, то происходит эффективный обмен: охлажденная на улице часть отбирает тепло изнутри, а нагретая – охлаждается внешним воздухом. При этом перетоки воздуха между дата-центром и улицей остаются незначительными, при каждом полуобороте происходит обмен порядка самого геометрического объема диска ротора.

По сравнению с неподвижными радиаторами той же производительности ротор оказывается в несколько раз компактнее. Для примера: при диаметре 5,5 м и толщине 20 см вращающийся со скоростью 10 об/мин ротор переносит до 600 кВт тепла. При такой схеме исключается необходимость прокачивать жидкий теплоноситель. Вращение ротора на хороших подшипниках требует всего около 1 кВт.

Теплообмен происходит по схеме воздух-металл-воздух, т. е. теплу необходимо преодолеть всего две границы. Поскольку применен принцип противотока, передача тепла может происходить даже при разнице температур в 1 °С.

Естественно, когда на улице жарко, приходится подключать холодильные машины. Они встроены в установку и работают по так называемой схеме DX (direct expansion air conditioning), т. е. без промежуточного теплоносителя. Конденсатор размещен во внешнем контуре, а испаритель во внутреннем. При уличной температуре почти до 30 °С роторный теплообменник работает параллельно с холодильными машинами и берет часть работы на себя. В санкт-петербургском климате только 0,1% времени в году, т. е. в самые жаркие часы самых жарких дней, ротор останавливается и вся работа по охлаждению выполняется холодильными машинами.

В качестве бонуса мы получаем отсутствие риска протечек жидкого теплоносителя и минимальную трудоемкость обслуживания, которое сводится практически только к заменам воздушных фильтров один или два раза в год.

На сегодняшний день в мире работают около 500 установок KyotoCooling суммарной производительностью 210 МВт. Модельный ряд состоит из установок от 50 кВт до 1280 кВт различного исполнения.

Практика эксплуатации установок показывает, что незачем переносить дата-центр за полярный круг. Даже в умеренном климате Санкт-Петербурга вполне реально достичь среднего по году уровня энергозатрат на охлаждение не более 12–14% от потребления ИТ-оборудования. При этом дополнительно снимается риск протечек теплоносителя и необходимость его утилизации в больших объемах при замене.

Конечно, применение такого подхода зачастую требует строительства нового здания, но если относиться к дата-центру, как к индустриальному объекту, то ничего страшного в этом нет. Никто же не пытается вписать сборочный цех в обычное офисное здание. Повышение экономичности и надежности оправдывают строительные расходы, на самом деле вполне умеренные.

Рис. 3. Серийная сборка установок по 400 кВт на заводе в штате Огайо (фото автора)