Компания Data Sapience провела Kolmogorov Online Day. Эксперты раскрыли детали эффективного управления жизненным циклом языковых моделей, рассказали, в чем ценность сотрудничества специалистов в области Data Science и бизнес-аналитиков, как повысить отдачу от ML-инвестиций.

Открывая конференцию, ее модератор, руководитель развития бизнеса Kolmogorov компании Data Sapience Илья Маршаков рассказал о возможностях аналитической платформы Kolmogorov, которая разрабатывается с 2018 г. выпускниками ВМК МГУ. Решение названо в честь Андрея Колмогорова – выдающегося математика. Модульная платформа полного цикла для разработки ML-моделей, включенная в реестр российского ПО, состоит из различных компонентов для решения точечных задач.

Открывая конференцию, ее модератор, руководитель развития бизнеса Kolmogorov компании Data Sapience Илья Маршаков рассказал о возможностях аналитической платформы Kolmogorov, которая разрабатывается с 2018 г. выпускниками ВМК МГУ. Решение названо в честь Андрея Колмогорова – выдающегося математика. Модульная платформа полного цикла для разработки ML-моделей, включенная в реестр российского ПО, состоит из различных компонентов для решения точечных задач.

Платформа предоставляет инструментарий, необходимый для создания классических ML-моделей, и широкие возможности для Deep Learning. Kolmogorov позволяет специалистам Data Scientist решать любые задачи, упрощает работу сотрудников смежных подразделений бизнеса и ИТ. С помощью ряда инструментов, доступных на базе платформы, удобно формировать дата-сеты для последующего обучения моделей.

Ядро платформы рассчитано на использование библиотек и алгоритмов для решения классических ML-задач, статистической и графовой аналитики, создания ИИ-агентов. Функциональность платформы дает возможность отслеживать качество данных и моделей, свести к минимуму риски возникновения ошибок по вине человека, отказаться от рутинных процессов и высвободить ресурсы специалистов в сфере Data Science для решения креативных задач в области ML.

По словам модератора, платформа Kolmogorov призвана сократить сроки вывода моделей в промышленную эксплуатацию (с нескольких месяцев до часов и дней), повысить их качество, а также снизить расходы на их поддержание.

От экспериментов к платформе MLOps

Большое внимание на конференции было уделено практикам управления жизненным циклом моделей машинного обучения (MLOps) в крупных компаниях, рассматривались подходы к внедрению машинного обучения, особенности масштабирования и ограничения ML-решений. Реализация концепции MLOps – одно из условий продуктивного использования ИИ-инструментов в бизнес-процессах.

Сегодня все говорят про ИИ, но зачастую забывают о том, что для получения результатов нужна предварительная работа, в частности с данными. На это обратил внимание аудитории независимый эксперт в области цифровой трансформации, менеджмента и управления данными Владимир Анисимов. Чтобы масштабировать ИИ без сбоев и перерасхода ресурсов, требуется платформа MLOps, обеспечивающая управление жизненным циклом моделей.

Сегодня все говорят про ИИ, но зачастую забывают о том, что для получения результатов нужна предварительная работа, в частности с данными. На это обратил внимание аудитории независимый эксперт в области цифровой трансформации, менеджмента и управления данными Владимир Анисимов. Чтобы масштабировать ИИ без сбоев и перерасхода ресурсов, требуется платформа MLOps, обеспечивающая управление жизненным циклом моделей.

По словам эксперта, MLOps живет только в продуктивной среде. Если обучать модель на «синтетике», не стоит рассчитывать на получение качественного результата на практике. Чем ближе процесс к реальным данным, которые используются в рамках обучения, тем выше результаты и лучше показывает себя модель.

В ходе эволюции MLOps прошел путь от базовых практик к комплексным решениям, поддерживающим все аспекты жизненного цикла ML-моделей.

Пять столпов инфраструктуры

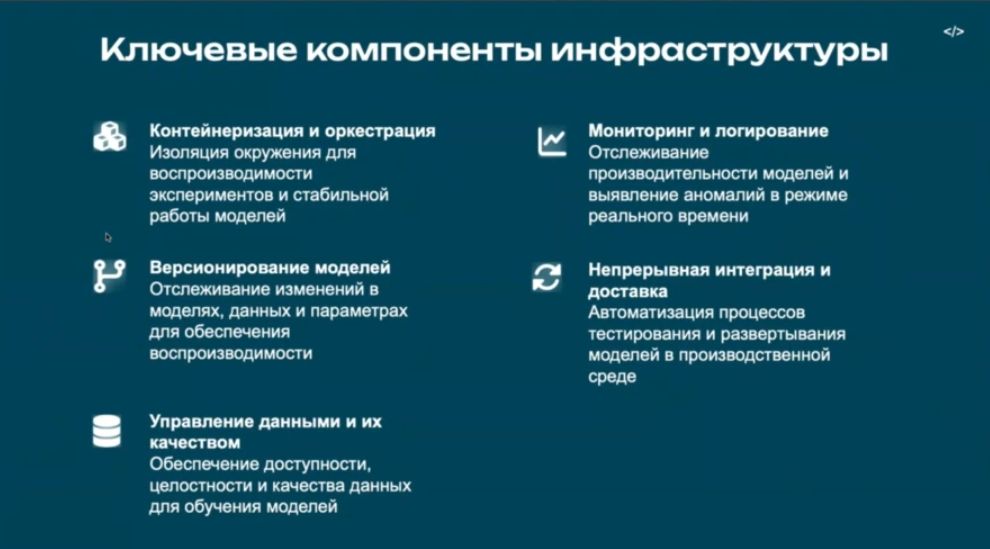

О ключевых компонентах (столпах) инфраструктуры рассказал независимый эксперт, владелец продукта AI Infrastructure Артем Аксёнов.

О ключевых компонентах (столпах) инфраструктуры рассказал независимый эксперт, владелец продукта AI Infrastructure Артем Аксёнов.

Первым он назвал контейнеризацию и оркестрацию. Моделям необходима изоляция окружения для воспроизводимости экспериментов и стабильной работы, а соответствующим окружением нужно управлять.

Второй столп – версионирование моделей, которое позволяет отслеживать изменения в самих моделях, данных и параметрах для обеспечения воспроизводимости.

Второй столп – версионирование моделей, которое позволяет отслеживать изменения в самих моделях, данных и параметрах для обеспечения воспроизводимости.

Третий – управление данными и их качеством, чтобы обеспечить доступность, целостность и уровень данных для обучения моделей. По словам эксперта, если на входе в модель мусор, то и на выходе из нее ни на что иное рассчитывать не стоит.

Четвертый столп – мониторинг и логирование, необходимые для аудита того, что имеется в хозяйстве. Мониторинг дает возможность в режиме реального времени проверять наличие отклонений в моделях, бизнес-метриках и оперативно на них реагировать.

Кроме того, мониторинг служит триггером запуска конвейера, т. е. непрерывной интеграции и доставки моделей в производственную среду благодаря автоматизации процессов тестирования и развертывания моделей (пятый столп). Разработанную модель нужно быстро внедрить, а затем следить, чтобы она своевременно переобучалась, не допуская снижения бизнес-метрик.

Подходы к масштабированию

Эксперты представили общемировые подходы к масштабированию MLOps: продуктовый, платформенный и гибридный.

Эксперты представили общемировые подходы к масштабированию MLOps: продуктовый, платформенный и гибридный.

В рамках продуктового подхода жизненным циклом владеет доменная команда разработки, а платформенные инструменты минимальны. Для этого подхода также характерны ориентация на метрики продукта и быстрое принятие решений в домене.

Противоположный ему платформенный подход предусматривает централизацию как инструментов, с помощью которых ведется разработка, так и команды, которая этими инструментами пользуется.

Оптимальный (топовый) подход, по мнению эксперта, – гибридный, вобравший в себя лучшее от продуктового и платформенного: есть централизованные инструменты, и при этом сохраняется доменность команд.

Продуктовый подход используется для быстрого прототипирования, достижения «маленькой победы», демонстрации возможностей бизнесу и т. д., платформенный – для вывода в продуктив прототипов. Его сложнее масштабировать – требуются большие инвестиции в платформенную команду.

Гибридный подход представляет собой баланс скорости и единообразия. Его легко масштабировать на десятки и сотни моделей, команд, поскольку подход не привязан ни к командам, ни к инструментам. Критичными являются интерфейсы и каталоги артефактов.

Инфраструктура на вырост

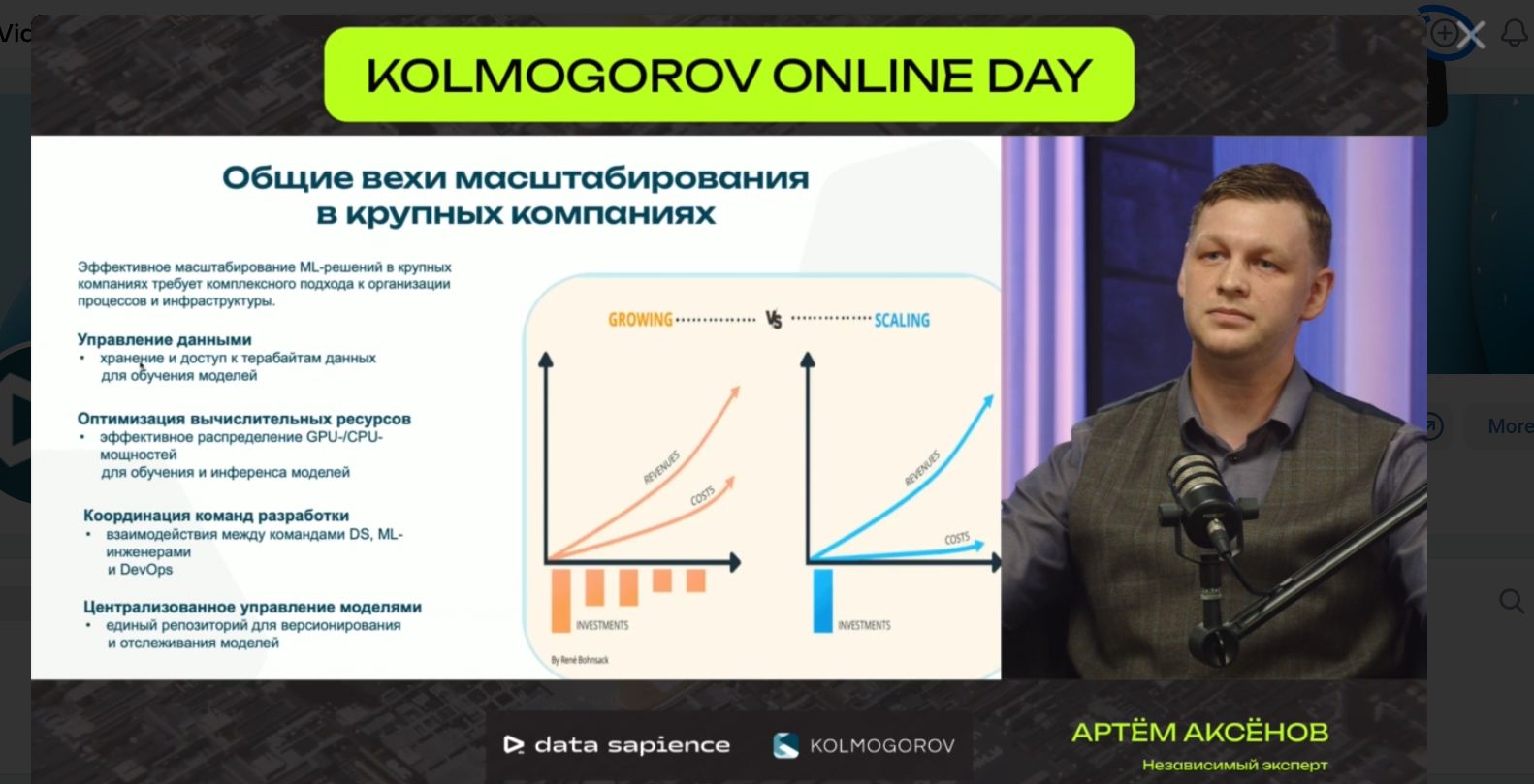

Как показывает опыт, для оптимизации расходов необходим комплексный подход к управлению данными, вычислительными ресурсами, координации команд разработки и централизованной координации моделей. Если решать такие задачи параллельно, достаточно будет проинвестировать один раз и избежать расходов в долгосрочной перспективе. Если отдать предпочтение последовательному решению задач, то потребуются постоянные вложения, что, в конечном итоге, невыгодно. Время от времени приобретать видеокарты, а потом думать, как собрать из них кластер, подходящий для современной модели, – нецелесообразно, подчеркивают эксперты.

Инфраструктура нужна на вырост, поскольку рынок моделей весьма динамичен, напоминает собой «маленькие революции в узком сегменте», которые меняют мир.

Технические ограничения при внедрении MLOps эксперты прокомментировали на основе общемировых практик. Основное – построение CI/CD-конвейера для ML-моделей, из которого вытекают иные технические ограничения. При построении такого конвейера, помимо безопасности, надо учитывать дрейф данных, воспроизводимость моделей. Не стоит забывать, что внедряется не просто модель, а продукт, основанный на ML-модели.

Что касается отечественной практики внедрения MLOps, то тут две новости (хорошая и плохая). На российском рынке появились достойные MLOps-платформы, однако усилия разработчиков упираются «в железо» (плохая новость). По словам Артема Аксёнова, с «иглы» зеленых видеокарточек пока не слезть («дорого и больно»). Альтернатива – смотреть в сторону китайских ускорителей. Но и там не без нюансов в софтовой части ускорителей: написание драйверов, отсутствие под них фреймворков.

Что касается отечественной практики внедрения MLOps, то тут две новости (хорошая и плохая). На российском рынке появились достойные MLOps-платформы, однако усилия разработчиков упираются «в железо» (плохая новость). По словам Артема Аксёнова, с «иглы» зеленых видеокарточек пока не слезть («дорого и больно»). Альтернатива – смотреть в сторону китайских ускорителей. Но и там не без нюансов в софтовой части ускорителей: написание драйверов, отсутствие под них фреймворков.

По мнению Владимира Анисимова, не все безнадежно. Российские ускорители появляются, пусть и не самого высокого уровня, но для ряда задач, например, связанных с видеоаналитикой, их можно использовать. Так что свет в конце туннеля виден.

Распространение концепции MLOps упирается не в алгоритмы, а в интеграцию с legacy-системами (в отсутствие слоя интеграции не ясно, что где и с чем работать). В центре внимания должна быть безопасность данных, поэтому не обойтись без сквозного мониторинга. Большие данные – большая ответственность.

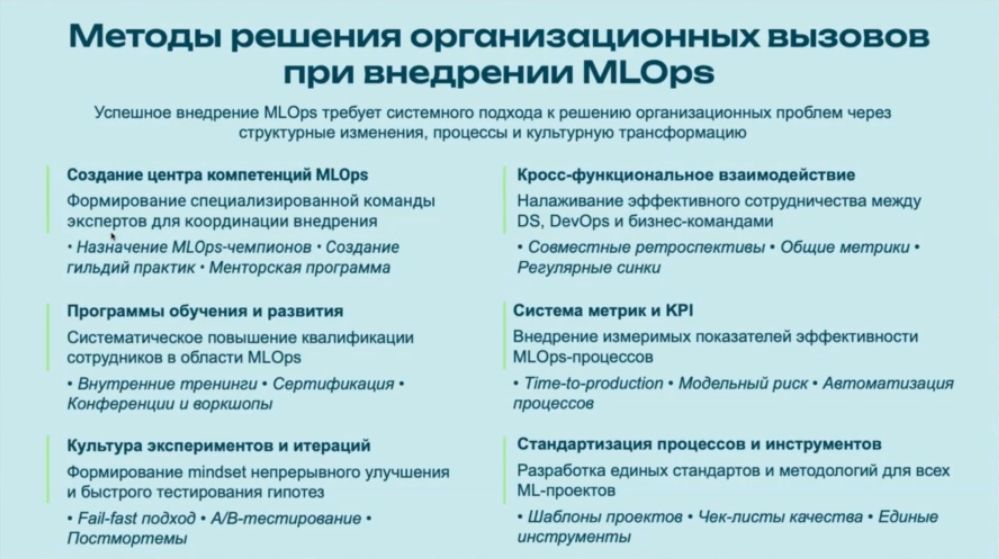

При внедрении MLOps следует учитывать не только технические, но и организационные ограничения. Важно правильно сформировать MLOps-команды с компетенциями в ML, DevOps и предметной области, стандартизировать процессы, управлять знаниями и при этом координировать действия айтишников и датасайентистов.

Опытом решения подобных задач поделился Владимир Анисимов. Ключевой метод – системный подход, предусматривающий структурные изменения, оптимизацию процессов и культурную трансформацию. Начинать эксперт рекомендует с создания центра компетенций MLOps. Сформированная на его базе команда отвечает за координацию внедрения.

Не лишними будут создание открытого сообщества, проведение внутренних хакатонов, поможет и обмен мнениями. Обязательный элемент – программа обучения. Из тех, кто активно проявляет себя в сообществе, можно сформировать группу амбассадоров, которые охотно делятся практиками.

Не следует упускать из виду кросс-функциональное взаимодействие – налаживание сотрудничества между DS-, DevOps- и бизнес-командами («святая троица хорошо решает задачки, если договорятся»). В итоге, как сказал эксперт, выстраиваются процессы, слои наработки пакуются в контейнеры.

В части мотивации и KPI многое решает среда. Если атмосфера здоровая, то в ряде случаев сотрудники готовы жертвовать зарплатой, а если агрессивно-грустная, то стимулом служат исключительно деньги. Методики управления целями и ключевыми показателями эффективности оказывают влияние на продуктивность.

В целом MLOps внедряется не в систему, а в культуру компании, сделали вывод эксперты.

Будущие тренды

За ИИ-агентами будущее. С каждым годом будет увеличиваться количество задач, которые делегируются ИИ. Появляется кадровая практика, когда до приема на работу человека проверяется, сможет ли с задачами будущего сотрудника справиться ИИ-агент. Если да, то делается ставка на дальнейшее развитие внутренней автоматизации.

За ИИ-агентами будущее. С каждым годом будет увеличиваться количество задач, которые делегируются ИИ. Появляется кадровая практика, когда до приема на работу человека проверяется, сможет ли с задачами будущего сотрудника справиться ИИ-агент. Если да, то делается ставка на дальнейшее развитие внутренней автоматизации.

В ряде задач ИИ-инструменты превосходят возможности человека. Однако пока нет программных помощников, которые, например, отправились бы на заседание бюджетного комитета и обосновали инвестиционную составляющую того или иного проекта.

Тем не менее искусственный интеллект – часть повседневной жизни человека (смартфоны, умные камеры). Мультиагентные системы умеют создавать интернет-ресурсы. Сайт-визитку можно оформить всего за час, 45 минут из которого человек будет составлять промт. Концепцию сайта можно продумывать, используя популярные модели. Владимир Анисимов в своей работе, например, прибегает к помощи таких моделей, как ChatGPT, Deepseek, Qwen, Perplexity, Manus и Grok. Согласно его прогнозу, персональными ассистентами все мы обзаведемся совсем скоро (год-три). Правда, многое будет зависеть от скорости развития технологий.